interaktive Anwendungen in Computermusik und Medienkunst

von Audio, Midi und Video mit objektorientierter Programmierung in

Max/msp/nato/GEM/Jitter.

interaktive Anwendungen in Computermusik und Medienkunst

von Audio, Midi und Video mit objektorientierter Programmierung in

Max/msp/nato/GEM/Jitter.

Möglichkeiten der Interaktivität von Bild und Klang:III) algorithmische Komposition, interaktive Musik, Computermusik

a) Sound -> Sound

b) Sound -> Image

c) Image -> Sound

d) Image -> Image

e) Mischformen

a) Synchronisation traditioneller Notenschrift mit Zeitwerten des ComputersIV) interaktive Kommunikation in der Medienkunst

Darstellung der zeitlichen Einsätze als rhythmische Werte

b) max zur Strukturierung komplexer zeitlicher Abläufe

c) Midisteuerung externer Devices

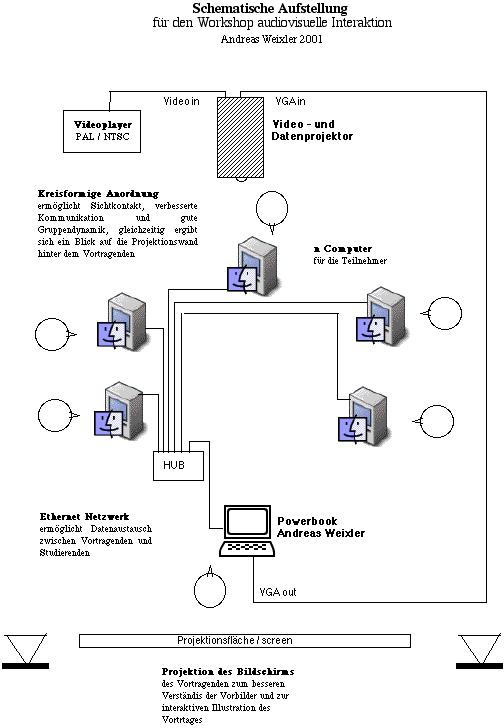

Bergische Universität Wuppertal, Workshop audiovisuelle Interaktion und Max/Msp/Jitter

Lehrstuhl für Visuelle Kommunikation, Prof. Hans Günter Schmitz, organisiert von Wolfram Zwanziger, 12.-14.Juli 2004

Dongeui University, Pusan, Süd-Korea, Vortrag für die Pusan Electronic Music Association: From Minimal to Audiovisual, 13. November 2003

TNCA Applied Music Department, Tainan National College of the Arts, Taiwan, 21. + 22. April 2003

Institut für Neue Musik, Staatliche Hochschule für Musik Freiburg, 7.-9. Februar 2003

Schloß Weinberg, Oberösterreichisches Studienzentrum, Vortrag am 7. Mai 2002, Veranstaltung des Bruckner-Konservatoriums Linz

Institut für Elektronische Musik und Akustik, Kunstuniversität Graz, Vortrag und Workshop am 5. und 10. Dezember 2001, und Gegenüberstellung MAX/MSP und PD mit Winfried Ritsch und Johannes Zmölnig IEM.

National Taiwan University of Arts, Taipeh 13. November 2001, zusammen mit Se-Lien Chuang, auf Chinesisch und Englisch.

Hochschule für Grafik und Buchkunst Leipzig, 16. - 17. Juli 2001, in deutscher Sprache

Nagoya City University - School of Design and Architecture, Japan, 19. Jänner 2001, mit Se-Lien Chuang und Mikako Mizuno auf Japanisch und English.

Das Ziel ist es die vielfältigen Einsatzmöglichkeiten und

die Flexibilität objektorientierter Programmierung mit Max/msp zu

verdeutlichen.

Der Workshop ist sowohl für den Ersteinstieg als auch für

Fortgeschrittene in Computermusik und interaktiver Medienkunst von

Interesse.

Den Studierenden werden Kenntnisse vermittelt, die verschiedene

Anwendungsgebiete

in algorithmische Komposition und Echtzeitsteuerung von Strukturen,

Audio

und Video zeigen, ebenso wie Anregungen für die eigene

künstlerische

Arbeiten gegeben. Präsentationen originaler Kompositionen und

Kooperationen

in der Medienkunst erläutern den Ansatz und die Realisierung

solcher

künstlerischer Projekte. Die Teilnehmer werden eigene Objekte in

MAX

unter professioneller Anleitung programmieren und neue

Realisationsmöglichkeiten

ihrer künstlerischen Ideen erarbeiten.

Der Workshop beinhaltet drei ineinander verschränkte Bereiche:

1) Die Vorstellung eigener Anwendungen in künstlerischer Arbeit und erfolgter Kooperation mit anderen Künstlern und Kunstformen.Stichworte

2) Das Erlernen des objektorientierten Programmierens und Übungsmöglichkeiten mit MAX/msp/nato/GEM/Jitter unter fachlicher Betreuung.

3) Beispiele verwandter und fortführender Anwendungen in Virtual und Mixed Reality anhand von Videos aus Austellungen in Japan 2001

Objektorientierte Programmierung mit MAX

- algorithmische Komposition, interaktive Musik, Computermusik

- Präsentation von künstlerischen Projekten

- MAX: interaktive Steuerungen, Strukturierung komplexer zeitlicher Abläufe, Midisteuerung externer Devices

- MAX/MSP: Computermusik, digitale Klangverarbeitung

- NATO: Realtime Video Processing

- GEM ermöglicht eine grafische Interaktion durch Einbindung des OpenGL Standards

- JITTER, Realtime Video Processing, Animation u.v.a.m, vereint die Möglichkeiten von Quicktime video und OpenGL animation in einer eigenen sehr gut dokumentierten Library. Organisation und Manipulation von Daten in einer Matrix.

- interaktive Kommunikation in der Medienkunst

- Vernetzung von Midi, Audio und Videodaten

- Audiovisuelle Interaktivität:: Sound -> Sound, Sound -> Image, Image -> Sound, Image -> Image

MAX ist eine objektorientierte, grafische Programmier-

oberfläche

und wurde ursprünglich, Anfang der neunziger Jahre, für den

Einsatz

von MIDI (Protokoll zur Steuerung von Synthesizer und Samplern)

entwickelt

und überzeugte durch sein musik- und kunstspezifisches Design.

Heute

ist es möglich, auch komplexe Midi-, Audio- und Videosteuerungen

mit

MAX zu realisieren.

Die Struktur ist offen, was nicht nur die interne Signalverarbeitung,

sondern auch die zur Steuerung herangezogenen externen Signale

betrifft.

Dies können neben Midicontrollern, Kameras, Mikrofone, Sensoren

und

auch Internetservices sein.

Der modulare Aufbau lässt beliebige Kombinationen zu. Dabei

kann

das aus einem externen Impuls generierte Signal wiederum zur Steuerung

und Generierung anderer Prozesse herangezogen werden. Alle Komponenten

können sowohl der Eingabe als auch Ausgabe dienen.

Der wesentliche Unterschied zu gängigen Audio-, Midi- und

Videosystemen

ist die Vereinigung unter einer Oberfläche und die freie

selbständige

Gestaltung der Interaktion.

Über Schnittstellen lassen sich Informationen, die von anderen

Hardwarekomponenten oder Softwareprogrammen verarbeitet wurden, in MAX

integrieren. Die daraus resultierende Flexibilität macht MAX zu

einem

leistungsfähigen, vielseitigen System.

I) Vernetzung der Datenströme von Audio, Midi und Video in Max/msp/nato/GEM/Jitter

II) audiovisuelle Interaktivität

Möglichkeiten der Interaktivität von Bild und Klang:III) algorithmische Komposition, interaktive Musik, Computermusik

a) Sound -> Sound

b) Sound -> Image

c) Image -> Sound

d) Image -> Image

e) Mischformen

a) Synchronisation traditioneller Notenschrift mit Zeitwerten des ComputersIV) interaktive Kommunikation in der Medienkunst

Darstellung der zeitlichen Einsätze als rhythmische Werte

b) max zur Strukturierung komplexer zeitlicher Abläufe

c) Midisteuerung externer Devices

V) Über meine künstlerische Arbeit und Vorgangsweise

kurzer Lebenslauf

Das Aussergewöhnliche an objektorientierter Programmierung mit Max/msp mit nato und GEM bzw mit Jitter ist die Vernetzung und Kombination unterschiedlichster Datenströme. Alle Daten können als Eingabe und als Ausgabe fungieren (Midi, Audio, Video)

1) Numerische Berechnungen

Wie in den meisten Programmiersprache lassen sich einfache mathematische Berechnungen bis zu komplexen logischen Aufgabenstellungen ausführen.2) MIDI

Die Implementierung des MIDI Standards ermöglicht die Kommunikation mit elektronischen Klangerzeugern sowohl als Eingabegerät als auch zur Steuerung externer Geräte.3) DSP

Mit msp eröffnet sich die Welt des DSP (Digital Sound Processing), z.b. Sampling, FFT, Analyse, Resynthese u.a.4) GRAFIK

Das LCD Objekt in MAX erlaubt einfache Grafiken aus Kreisen, Rechtecken und ähnlichem zusammenzusetzen und interaktiv zu verändern. Die Ausgabe der Maus Position machte es auch zum Eingabeobjekt. Die Portation von GEM durch Shigeyuki Hirai (Kyoto) aus PD auf die Macintosh-Plattform erschließt die grafischen Möglichkeiten des OpenGL Standards.5) NATO

mit Nato werden alle Quicktime Video Funktionen in Max eingebunden, wieder sowohl als Eingabe als auch als Ausgabe von Daten.6) JITTER

auch mit Jitter werden alle Quicktime Video Funktionen in Max eingebunden, verbunden mit OpenGL Technik für Animationen. Verwaltung der Daten in mehrdimensionalen Matrixen.7) 3rd party video

Es gibt noch andere 3rd party externals die Grafiken und 3D Darstellung ermöglichen z.B. max3d von Shuichi Chino. Für video analyse und Prozessierung gibt es einige 3rd party Objekte, die den Vorteil haben kostenfrei im Interne vertrieben zu werden. z.B. o- von Ichi, mov von Shuichi Chino, videoin von Erik Singer

Das SCRIPT

Diese einzelnen Modul-Systeme lassen sich in beliebigen

Parametern untereinander vernetzen, mappen oder algorithmisch

voneinander

abhängig machen.

Dies geschieht unter Einsatz der numerischen

Fähigkeiten

der Programmiersprache (Punkt 1) und ich nenne dies gerne das SCRIPT.

Es

bestimmt wie das (selbst) verfaßte System reagiert und kann auf

alle

Möglichkeiten wie Midi, Audio, Video und Grafik zugreifen, diese

mehrfach

untereinander verknüpfen und jeder dieser Daten als Eingabe und

Ausgabe

fungieren lassen.

In diesem Sinn empfehle ich eine Teamarbeit in

Aufteilung

und Spezialisierung einzelner Bereiche um komplexe Programme zu bilden.

Als Einzelpersonen bleibt einem das schrittweise Erlernen und

Experimentieren

in mehreren Phasen.

Das Anlegen von eigenen Bibliotheken (libraries)

lässt

einmal bereits Erforschtes und programmierte Klein-Patches

wiederverwenden.

Eine wohl überlegte Architektur und Terminologie sind

Voraussetzung

für eine weitere Verwendung in mehreren unterschiedlichen Patches.

(z.B. KHE rtc lib)

Beispiel WAON.

Der interaktiven audiovisuellen Performance WAON

(Andreas

Weixler 2000) liegt ein Max/msp Patch zugrunde, das diese

Modulhaftigkeit

genau einhält. Dies hat auch den Vorteil gut funktionierende Teile

des Patches in andere zu übernehmen und die Entwicklung neuer

Patches

zu beschleunigen.

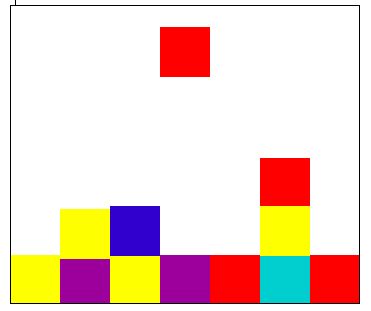

(vergleiche visuelle Darstellung in Algotetrix von

Se-Lien

Chuang 2002)

Waon

interaktive audiovisuelle Performance für 2

Instrumente

von Andreas Weixler.

Beschreibung: Nach der Idee des japanischen Harmoniebestrebens in der Kommunikation generiert der Computer eine Grafik und einen elektronischen Klang, die die Harmonie in der Improvisation zweier Instrumente wiederspiegeln.

UA: 15.12.2000 Experimental Intermedia, New York, USA

weitere Aufführung: VNM Festival 2001 Graz,

Österreich

ausgewählt für die ISEA 02, International

Symposium

of Electronic Art, in Nagoya, Japan

Möglichkeiten der Interaktivität von Bild

und

Klang:

a) Sound -> Sound, b) Sound -> Image, c) Image

-> Sound,

d) Image -> Image

a) Sound -> Sound

a1) Die Dynamik eines Instrumentes steuert einen Sampler via Midi.

O.zon (Andreas Weixler & Se-Lien Chuang 1997)

UA 2.8.97 14. Künstlerbegegnung St. Lambrecht;

Weitere Aufführungen. 3.11.97 Institut für

Elektronische Musik,Graz, 12.05.99 Lüneburg 21. internationale

Studienwoche

zeitgenössischer Musik

Hardware: PowerMac 7200/90, Ensoniq EPS 16+, Tx802

Software: Opcode-MAX

Interpreten: Se-Lien Chuang, Klavier; Andreas Weixler,

Computersystem

Dauer: 12´

a2) Echtzeitprozessierung von Klängen

a crush on You live at Experimental Intermedia, New York, USA

a crush on You live at Experimental Intermedia, New York, USA

a crush on You

interaktives Werk für das chinesische

Saiteninstrument

Yan-Zin und Macintosh Computer mit Max/msp

Studio: SUSS Sheffield University Sound Studio und

Atelier

Avant, 1999

Konzept und Max/msp Programmierung: Andreas Weixler

Yan-Zin: Se-Lien Chuang

UA: 25.09.1999 Weingut Gasser, Steiermark

weitere Aufführungen: Festival Elektrokomplex 99

am 12.12.1999 im Rhiz Wien, 22.09.2000 Stadtapotheke Trofaiach

(Österreich),

15.12.2000 Experimental Intermedia New York, 19.01.2001

Nagoya City University, Japan

diverse Radiosendungen.

The Story of H e i k e

interaktive audiovisuelle Erzählung

Beschreibung: Der Biwa Player erzählt die

traditionelle

japanische Geschichte von Heike.

Der Computer mißt die Aktivität von

Instrument

und Stimme und wählt die begleitenden Bilder und deren

Transformationen

aus. ca. 20´

Kagusho Kitagawa, Biwa

Mikako Mizuno, art concept

Se-Lien Chuang, visuals & realtime arrangement

Andreas Weixler, interactive programming

Premiere: Nagoya City University - School of Design

and

Architecture, Japan, 16. Februar 2001, Sound Lab

Technik: Max/msp (fiddle~ objekt zur Analyse von

Tonhöhe

und Dynamik, algorithmische Datenprozessierung), und X-Pose Visual

Sampler.

mov

die Bewegung eines Videos von Se-Lien Chuang wird

durch

Tonhöhen gesteuert oder auch der Blickwinkel einer Kamera im

Soundstudio

der Nagoya City University.

Hier zwei Beispiele eines mit dem Nato Objekt 242.pupille und die Softare BigEye von STEIM in Amsterdam.

Ouroboros

interaktive Klangmodulation von Andreas Weixler zum

Kunst-Video

"Ouroboros" von Gertrude Moser-Wagner (2000)

Im Konzept der Vertonung des Kunst-Videos versuchte

ich

die künstlerischen Vorgaben des Gesamt-Konzeptes im Bereich des

Hörens

nachzuvollziehen.

Eine Version Klangmodulation durch audiovisuelle

Interaktivität

steuert durch digitale Beobachtung des radioaktiven Leuchtpunktes am

Gen-Objekts,

des Wurms ROL 6, die digitale Klangprozessierung.

produziert im Atelier Avant Aweixler

Hardware: PowerMacintosh 7200, Software: Max/msp 3.5.9,

Nato.

www.art-metabolism.com

Origami

Japanisches Origami-Papier steuert digitale

Klänge.

Experimente mit BigEye für das Object-Tracking. Die Midi Daten

werden

in Max/msp weiter verarbeitet (Ton, Bild).

Living Cave in Laval Virtual, Frankreich

Living Cave in Laval Virtual, Frankreich

a) Synchronisation traditioneller Notenschrift mit Zeitwerten des Computers

Darstellung der zeitlichen Einsätze als

rhythmische

Werte

Computer "denken" zeitlich meist in Millisekunden (ms),

während Musiker mit traditioneller Notenschrift Zeit in

Proportionen

zu einem Puls messen. Will man nun eine computergenerierte Komposition

mit traditioneller Notenschrift verbinden, gilt es vergleichbare

Verhältnisse

zu schaffen.

Einfach zu berechnen ist ein Grundtempo von 60. Das

heißt,

pro Minute werden sechzig Schläge gezählt, was wiederum

heißt,

jede Sekunde einer.

Daraus ergibt sich die logische Teilung in Sechzehntel:

Man kann also erkennen, daß die Auflösung an den beiden Rändern, bei 0 und 1 Sekunde, und in der Mitte bei einer halben Sekunde gröber als bei den Zwischenwerten ist; und aus der rhythmischen Teilung ergibt sich natürlich eine Zahlensymmetrie.

in der Zeit des Blühens (A.Weixler 2000)

algorithmische Komposition für traditionelles

chinesisches

Instrumentalensemble

Besetzung: dongxiao, sheng, pipa, guhzeng, daruan,

yanzin,

erhu und percussion

Dauer: 07:00

Interpreten: China Found Music Workshop - Taipeh/Taiwan

UA: 05.04.2000 Konzerthaus Wien, Hörgänge

Man sieht deutlich die Verdichtung der Rhythmen. Die zeitliche Entwicklung ist mit einem Max patch generiert worden, anschließend als Midifile exportiert und in einem score edit Programm (Cubase) lesbar gemacht.

Die Partitur wurde dann handgeschrieben vom Komponisten interpretiert. (Siehe "Synchronisation traditioneller Notenschrift mit Zeitwerten des Computers, Darstellung der zeitlichen Einsätze als rhythmische Werte")

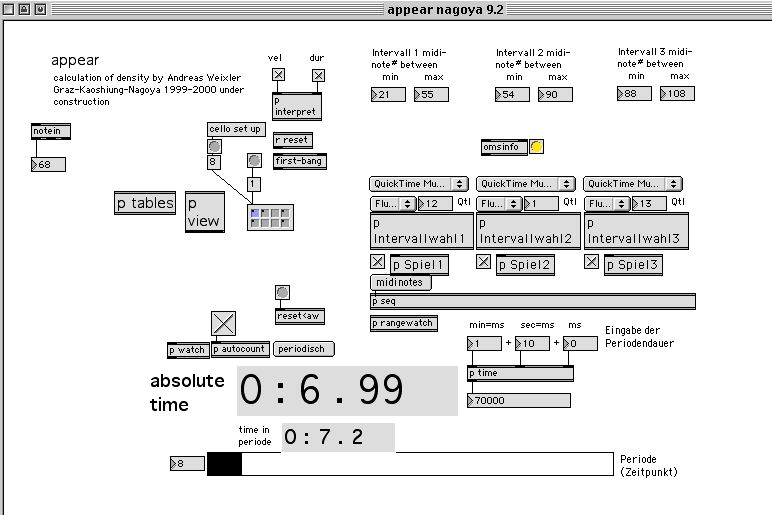

Das max patch "appear" zur Dichte Steuerung rhythmischer Events errechnet auch die Stimmzuteilung in der Instrumentation.

Soundbarrier, Instrumente werden im Live-Konzert über ein Mehrkanal-Lautsprechersystem spatialisiert, max-patch: LAP

HyperControl für HyperPrism

HyperControl ist ein Max-patch zur Steuerung der Software HyperPrism. Auf diese Weise kann die Klangprozessierung von HyperPrism algorithmisch gesteuert werden.

Jade for orchestra on tape ( A.Weixler 1996)

Beschreibung: Computerkomposition, algorithmische

gesteuerte

Klangprozessierung zeitgenössischer Orchesterklänge

Dauer: 5:54

Hardware: PowerMac 7200/90, Macintosh Quadra 650 div

Peripheriegeräte

Software: ProTools 16Track, TDM Plugins: HTD, BRN, GRM,

Hyperprism 1.5.2, GRM Tools 1.55, SoundDesigner 2.8, Alchemy 3.0,

HyperControl,

Max 3.0, Soundhack 0.8

Studios: University of East Anglia , Norwich, BEAST

Birmingham

Electro Acoustic Sound Theatre, England

UA: Kunsthalle Stockerau 31.8.96

weitere Aufführungen:

WUK Wien 3-13.10.96 ProjektTheater Wien-New-York,

15.10.96 Theatro Austrian Sound Check/Steirischer

Herbst

,

14.u.15.11.97 Projekttheater Eva Brenner-Minoriten Graz

,

26.6.1997 European Electroacoustic Music Festival in

Brüssel ,

11.2.98 Electroacoustic Music Concert Montreal/Canada

,

15. 01.98 Konzert "Musik des 20. Jahrhunderts" Tiroler

Landeskonservatoriums,

10.11.98 Sumida Triphony Hall-Tokio/Japan

13.03.1999 Lange Nacht der Neuen Klänge,

Konzerthaus

Wien

11.05.99 Lüneburg 21. internatinale Studienwoche

zeitgenössischer Musik

15.12.2000 Experimental Intermedia, New York

the cat and the mouse (Se-Lien Chuang 1999)

(Werktext von Se-Lien Chuang) Das Herausfordernde

und

Spannende im Stück ist, daß es ein interaktive Echt-Zeit

Spiel

zwischen Gitarre, Klavier und den Recheneinheit ist.

Die Musiker spielen, der Rechner Computer nimmt die

Musikklänge

in Echt-Zeit auf, prozessiert die Klänge, und speichert sie in

sich.

Die Musiker lösen die gespeichernden Klänge später zu

neu

improvisierenden Naturklängen von Instrumenten aus.

Kommunikation in mehreren Ebenen:

1. Die Improvisation als offensichtliche Kommunikation der Musizierenden (Gitarre/Klavier)Die Laptops versenden die digitalen Operationsbefehle der Interpreten an den Hauptrechner (ISPW) und sorgen für die wechselseitige Information untereinander.

2. Das Soundprocessing und die Daten-Koordination am Hauptrechner (ISPW)

3. verborgene Kommunikation zwischen den Musikern, der Hauptrecheneinheit und untereinander. (Laptops)

Auff. Festivals Elektronischer Frühling, Wien 1998, Lüneburg 21. internationale Studienwoche zeitgenössischer Musik 1999, VNM Festival Graz 1999

Konzept: Se-Lien CHUANG

ISPW- Max : Wolfgang MUSIL, Thomas MUSIL

Opcode- Max : Andreas WEIXLER

E-Gitarre: Andreas WEIXLER

präpariertes Klavier: Se-Lien CHUANG

Das Stück wurde produziert am Institut für

Elektroakustische,

Experimentelle und Angewandte Musik in Wien/Österreich, Institut

für

Elektronische Musik in Graz/Österreich und im Atelier Avant in

Graz/Österreich

Ich verwende Kombinationen verschiedener Software

zur

Schaffung von Computermusik und Medienkunst. Im Unterricht lege ich

meinen

Studenten nahe ihre eigenen Wege zu suchen in der Verwendung und

Verbindung

von Software. Mein Bedürfnis der Verfügbarkeit eigener

Programme

und Kompositions-Hilfen wurden durch objektorientierte

Programmiersprachen

wie Max für ISPW (IRCAM Sound Processing Workstation) und

heutzutage

Max/msp oder PD als ein sehr guter künstlerischer Zugang

erfüllt.

In meiner künstlerischen Arbeit verwende ich

natürlich

auch Standard-Software für Harddiskrecording, Sequencing,

Notendruck

und Datensicherung und nicht zuletzt zählen auch Papier und

Bleistift

zu unverzichtbaren Utensilien. In Computermusik kreierte ich Werke

verschiedenster

Richtung; alle Werke gehören in einen gemeinsamen Strom von "work

in progress", der einerseits durch die zum jeweiligen Zeitpunkt zur

Verfügung

stehende Technologie beeinflusst wird und andererseits in der Struktur

der Kompositionen erkennbar wird. Einige Stücke beziehen sich

aufeinander,

z.B. verwende ich Aufnahmen einer algorithmischen

Instrumentalkomposition

weiter als Basis zur Generierung elektronischer Klänge für

die

nächste Studioproduktion.

1) Midi controlled devicesObwohl diese Kategorisierung sehr klar wirkt, sind viele Werke oft mehreren Sparten gleichzeitig zuzuordnen.

- Sampler & Synthesizer (Glass Seele)

2) algorithmische Komposition

- Notendruck (Idem)

- Strukturgeneratoren (In der Zeit des Blühens)

3) Klang Prozessierung

- Studio Produktion (Jade)

- Mehrkanal-Systeme (Sound Barrior)

- Echtzeit-Prozessierung (a crush on You)

4) Interaktivität

- interaktive Komunikation (cat and the mouse)

- audio reagiert auf audio (o.zon)

5) audiovisuell

- Musik Video/audiovisuelle Komposition (blue elephant)

- Interaktivät

- sound process image (Living Cave)

- image process sound (Living Cave)

auch:

- image process image (Mov)

contact email: aweixler@sime.com

Zeitlich

Grundworkshop

Der Workshop ist sehr flexibel in der Dauer, als

erfahrungsgemäß

sinnvoll möchte ich 3 Tage á 5 Stunden, oder 2 Tage

á

6 Stunden vorschlagen für ein Kennenlernen von Max/msp,

Übungsmöglichkeit

für die Teilnehmer und der Vorstellung eigener Anwendungen in

künstlerischer

Arbeit .

Vortrag

alternative zum Grundworkshop, der eine aktive Einbindung der

Teilnehmer

zum Ziel hat, biete ich auch einen Vortrag über audiovisuelle

Interaktion

und eine Einführung in objektoerientierte Programmierung an. Dauer

etwa 2 Stunden.

Der technische Aufwand ist weitaus geringer, benötigt wird

lediglich

ein Videoprojektor und Lautsprecher. Computer und Software wird von uns

gestellt.

Schwerpunkt-Semester

Erweiterbar um weitere, wünschenswert auch regelmäßige,

Einheiten z.B. 14-tägig für ein Schwerpunkt-Semester. z.b. 6

Einheiten zu 2 Stunden über das Semester verteilt ergeben 12

Übungs-Stunden.

Termine

nach Vereinbarung

Ich bringe zum Workshop ein leistungsfähiges Macintosh PowerBook mit Software Max/msp/Jitter und Nato/Gem und einige begleitende Materialien.